基于零售交易數(shù)據(jù)的Spark數(shù)據(jù)處理與分析 賦能現(xiàn)代零售業(yè)的計(jì)算機(jī)軟件數(shù)據(jù)處理服務(wù)

在當(dāng)今數(shù)據(jù)驅(qū)動(dòng)的商業(yè)環(huán)境中,零售行業(yè)正經(jīng)歷著一場(chǎng)深刻的變革。海量的交易數(shù)據(jù)——包括客戶購買記錄、商品信息、時(shí)間戳、支付方式、門店位置等——不僅是日常運(yùn)營(yíng)的副產(chǎn)品,更是洞察市場(chǎng)趨勢(shì)、優(yōu)化運(yùn)營(yíng)策略、提升客戶體驗(yàn)的寶貴資產(chǎn)。傳統(tǒng)的數(shù)據(jù)處理方式(如關(guān)系型數(shù)據(jù)庫單機(jī)處理)在面對(duì)TB甚至PB級(jí)別的零售交易數(shù)據(jù)時(shí),往往在存儲(chǔ)、計(jì)算速度和擴(kuò)展性上捉襟見肘。此時(shí),以Apache Spark為核心的大數(shù)據(jù)處理框架,結(jié)合專業(yè)的計(jì)算機(jī)軟件數(shù)據(jù)處理服務(wù),為零售企業(yè)提供了強(qiáng)大的解決方案。

一、零售交易數(shù)據(jù)的挑戰(zhàn)與Spark的優(yōu)勢(shì)

零售交易數(shù)據(jù)通常具有4V特征:

- 體量大(Volume):連鎖門店、電商平臺(tái)每日產(chǎn)生數(shù)百萬乃至上億條交易記錄。

- 速度快(Velocity):數(shù)據(jù)流實(shí)時(shí)或近實(shí)時(shí)地涌入,如在線交易、POS機(jī)流水。

- 種類多(Variety):包括結(jié)構(gòu)化數(shù)據(jù)(交易表、商品表)、半結(jié)構(gòu)化數(shù)據(jù)(JSON格式的點(diǎn)擊流日志)和非結(jié)構(gòu)化數(shù)據(jù)(客服錄音、商品評(píng)論)。

- 價(jià)值密度低(Value):需要從海量數(shù)據(jù)中挖掘出高價(jià)值的商業(yè)洞察。

Apache Spark作為一個(gè)開源、統(tǒng)一的分析引擎,以其內(nèi)存計(jì)算、DAG執(zhí)行引擎、豐富的API(Scala, Java, Python, R)以及強(qiáng)大的生態(tài)系統(tǒng)(Spark SQL, MLlib, Structured Streaming, GraphX),完美應(yīng)對(duì)上述挑戰(zhàn)。其核心優(yōu)勢(shì)在于:

- 極高的處理速度:基于內(nèi)存的計(jì)算比基于磁盤的Hadoop MapReduce快數(shù)十到百倍,非常適合需要迭代計(jì)算(如機(jī)器學(xué)習(xí)模型訓(xùn)練)和交互式查詢的場(chǎng)景。

- 強(qiáng)大的流批一體化處理能力:Structured Streaming API使得用同一套代碼處理實(shí)時(shí)流數(shù)據(jù)和歷史批數(shù)據(jù)成為可能,便于構(gòu)建端到端的實(shí)時(shí)分析管道。

- 易用性與豐富的庫:高級(jí)API降低了開發(fā)復(fù)雜度,而Spark SQL便于進(jìn)行類SQL的數(shù)據(jù)查詢,MLlib提供了可擴(kuò)展的機(jī)器學(xué)習(xí)算法庫,非常適合零售領(lǐng)域的銷量預(yù)測(cè)、客戶分群等應(yīng)用。

二、基于Spark的零售數(shù)據(jù)處理與分析核心流程

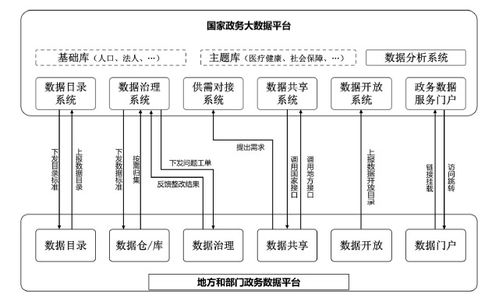

專業(yè)的計(jì)算機(jī)軟件數(shù)據(jù)處理服務(wù)會(huì)基于Spark構(gòu)建一個(gè)標(biāo)準(zhǔn)化的數(shù)據(jù)處理與分析管道(Pipeline),通常包含以下階段:

- 數(shù)據(jù)采集與集成:

- 使用Apache Kafka、Flume等工具從POS系統(tǒng)、電商平臺(tái)、移動(dòng)APP、傳感器等多元數(shù)據(jù)源實(shí)時(shí)或批量采集數(shù)據(jù)。

- Spark Streaming或Structured Streaming可以消費(fèi)Kafka中的數(shù)據(jù)流,實(shí)現(xiàn)實(shí)時(shí)攝入。

- 數(shù)據(jù)清洗與標(biāo)準(zhǔn)化:

- 利用Spark DataFrame API和Spark SQL進(jìn)行數(shù)據(jù)清洗,處理缺失值、異常值、重復(fù)記錄,統(tǒng)一數(shù)據(jù)格式和單位(如貨幣、日期)。

- 這是一個(gè)關(guān)鍵步驟,以確保下游分析的準(zhǔn)確性。

- 數(shù)據(jù)存儲(chǔ)與管理:

- 清洗后的數(shù)據(jù)可持久化存儲(chǔ)到分布式文件系統(tǒng)(如HDFS)、對(duì)象存儲(chǔ)(如AWS S3)或數(shù)據(jù)湖(如Delta Lake)中,為后續(xù)分析提供統(tǒng)一的數(shù)據(jù)源。

- Delta Lake等技術(shù)能在數(shù)據(jù)湖之上提供ACID事務(wù)、數(shù)據(jù)版本控制等能力,增強(qiáng)了數(shù)據(jù)管理的可靠性。

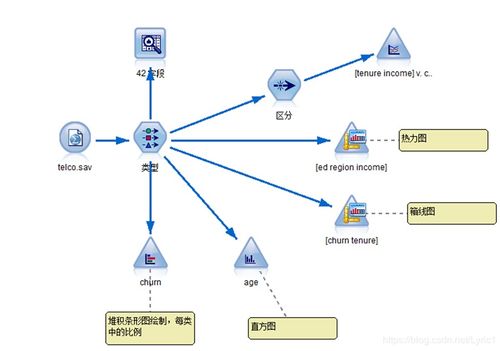

- 數(shù)據(jù)分析與挖掘:

- 即席查詢與報(bào)表:通過Spark SQL,分析師可以快速對(duì)海量歷史數(shù)據(jù)進(jìn)行復(fù)雜的聚合查詢,生成銷售報(bào)表、庫存周轉(zhuǎn)報(bào)告等。

- 客戶行為分析:利用Spark MLlib進(jìn)行聚類分析(如RFM模型對(duì)客戶價(jià)值分群)、關(guān)聯(lián)規(guī)則挖掘(購物籃分析,發(fā)現(xiàn)“啤酒與尿布”式關(guān)聯(lián)商品)。

- 銷售預(yù)測(cè)與需求規(guī)劃:使用MLlib中的時(shí)間序列分析或回歸算法,結(jié)合歷史銷售數(shù)據(jù)、促銷活動(dòng)、季節(jié)因素,預(yù)測(cè)未來商品銷量,優(yōu)化庫存。

- 實(shí)時(shí)個(gè)性化推薦:結(jié)合流處理與機(jī)器學(xué)習(xí)模型,對(duì)用戶的實(shí)時(shí)瀏覽和購買行為進(jìn)行分析,即時(shí)推送個(gè)性化商品推薦。

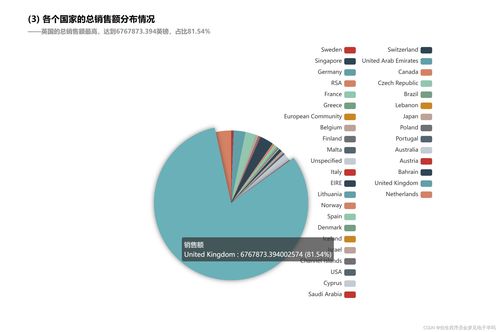

- 數(shù)據(jù)可視化與洞察交付:

- 將Spark處理后的結(jié)果數(shù)據(jù)輸出到OLAP數(shù)據(jù)庫(如ClickHouse)或可視化工具(如Tableau、Superset),生成動(dòng)態(tài)儀表盤,為管理者和運(yùn)營(yíng)人員提供直觀的業(yè)務(wù)洞察。

三、計(jì)算機(jī)軟件數(shù)據(jù)處理服務(wù)的價(jià)值體現(xiàn)

將上述技術(shù)流程封裝為專業(yè)的軟件數(shù)據(jù)處理服務(wù),能為零售企業(yè)帶來顯著價(jià)值:

- 降低成本與提升效率:通過自動(dòng)化的數(shù)據(jù)處理管道,替代大量手工報(bào)表工作,縮短從數(shù)據(jù)到洞察的周期,使數(shù)據(jù)團(tuán)隊(duì)能專注于高價(jià)值分析。

- 實(shí)現(xiàn)數(shù)據(jù)驅(qū)動(dòng)的決策:提供準(zhǔn)確、及時(shí)的商品熱銷分析、庫存預(yù)警、客戶流失預(yù)警等,輔助商品定價(jià)、促銷策略制定、門店選址等關(guān)鍵決策。

- 提升客戶體驗(yàn)與營(yíng)收:通過精準(zhǔn)的客戶分群和個(gè)性化營(yíng)銷,提高客戶轉(zhuǎn)化率、客單價(jià)和忠誠度。

- 構(gòu)建可擴(kuò)展的數(shù)據(jù)資產(chǎn):基于Spark和云原生架構(gòu)的解決方案具備良好的水平擴(kuò)展性,能夠伴隨企業(yè)業(yè)務(wù)增長(zhǎng)而平滑擴(kuò)展,形成持續(xù)增值的數(shù)據(jù)資產(chǎn)。

###

基于Apache Spark的零售交易數(shù)據(jù)處理與分析,已不再是單純的技術(shù)實(shí)驗(yàn),而是成為現(xiàn)代零售企業(yè)提升核心競(jìng)爭(zhēng)力的關(guān)鍵基礎(chǔ)設(shè)施。通過借助專業(yè)的計(jì)算機(jī)軟件數(shù)據(jù)處理服務(wù),企業(yè)能夠以更低的成本和更高的效率,將沉睡的交易數(shù)據(jù)轉(zhuǎn)化為可行動(dòng)的智慧,從而在激烈的市場(chǎng)競(jìng)爭(zhēng)中把握先機(jī),實(shí)現(xiàn)精細(xì)化運(yùn)營(yíng)和智能化升級(jí)。從批量報(bào)表到實(shí)時(shí)洞察,從模糊經(jīng)驗(yàn)到精準(zhǔn)預(yù)測(cè),Spark正驅(qū)動(dòng)著零售行業(yè)邁向一個(gè)全新的數(shù)據(jù)智能時(shí)代。

如若轉(zhuǎn)載,請(qǐng)注明出處:http://m.planethome.cn/product/61.html

更新時(shí)間:2026-01-07 14:12:25