計算機軟件數據處理服務 數字化時代的核心引擎

在當今信息爆炸的時代,數據已成為驅動社會發展的關鍵資源。而計算機軟件數據處理服務,則如同一個精密高效的大腦,對海量數據進行采集、存儲、分析、轉化與呈現,為各行各業提供決策支持與智能化解決方案。

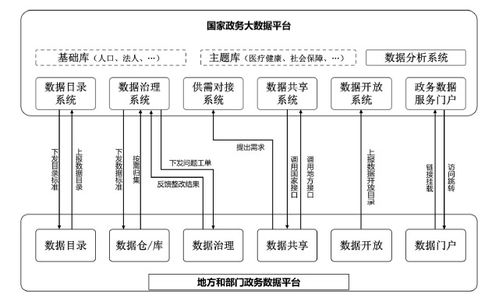

數據處理服務首先從數據采集與整合開始。通過各種接口、傳感器、日志記錄等方式,軟件系統將來自不同源頭、不同格式的結構化與非結構化數據匯聚到一起,并進行清洗、去重與標準化處理,為后續分析奠定高質量的數據基礎。這一過程確保了數據的完整性與一致性,避免了“垃圾進、垃圾出”的困境。

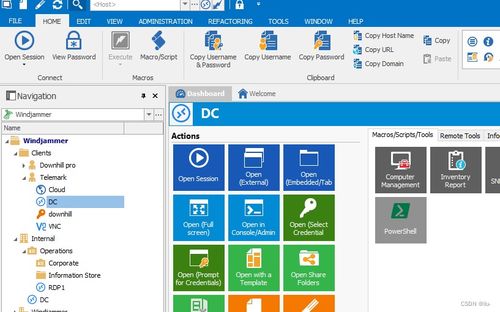

隨后是數據的存儲與管理。面對TB甚至PB級別的數據量,傳統存儲方式已力不從心。現代數據處理服務依托數據庫管理系統(如關系型數據庫MySQL、非關系型數據庫MongoDB)、數據倉庫(如Amazon Redshift)以及分布式文件系統(如Hadoop HDFS),實現了數據的安全、可靠與高效存儲。這些技術不僅保障了數據不丟失、不損壞,還能通過索引、分區等手段實現快速檢索與訪問。

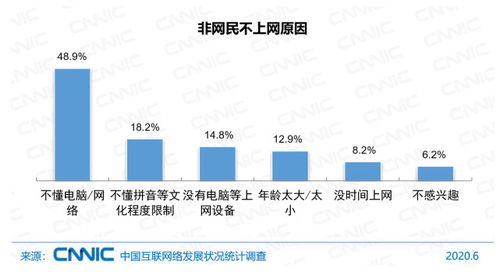

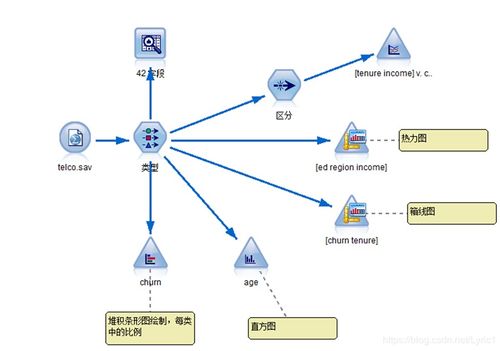

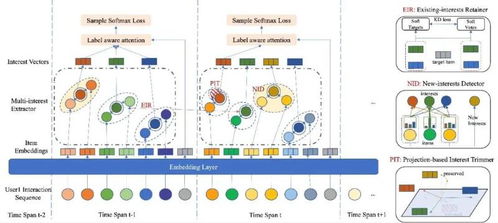

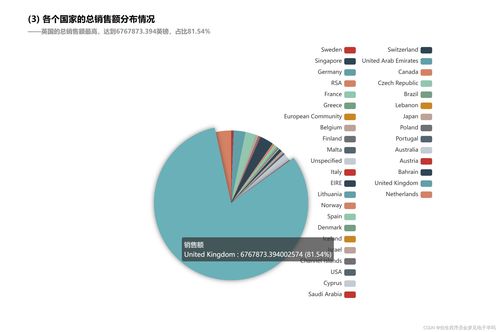

核心環節在于數據分析與挖掘。通過運用統計分析、機器學習、人工智能等算法,數據處理服務能夠從看似雜亂的數據中發現規律、趨勢和關聯。例如,在商業智能(BI)領域,它可以幫助企業分析銷售趨勢、用戶行為,優化營銷策略;在科學研究中,它能處理實驗數據,加速新發現;在公共安全領域,可協助進行模式識別與預測預警。這一過程將原始數據轉化為有價值的“信息”與“知識”。

數據處理服務的輸出形式多樣且貼近需求。它可以通過數據可視化工具(如圖表、儀表盤)將復雜結果直觀呈現,輔助管理者一目了然地掌握狀況;也能通過API接口將處理結果實時傳遞給其他應用系統,驅動自動化流程;或生成詳盡的報告,為戰略規劃提供依據。

隨著云計算、邊緣計算和物聯網技術的發展,數據處理服務正變得更加實時、智能與分布式。實時流處理技術(如Apache Kafka、Flink)使得對即時數據的分析成為可能,支持毫秒級的決策響應;而AI的融入則讓數據處理從被動分析走向主動預測與自主優化。

這一領域也面臨挑戰,包括數據隱私與安全保護、處理過程的能耗問題、以及對復合型人才的需求。計算機軟件數據處理服務將繼續演進,在確保安全、合規與綠色的前提下,更深層次地釋放數據潛能,成為推動數字化轉型與智能化升級不可或缺的核心引擎。

如若轉載,請注明出處:http://m.planethome.cn/product/57.html

更新時間:2026-01-05 20:40:45